android

两轮自平衡小车设计

ROS2

趣味python

进程

vscode

SystemVerilog

list

程序

RE理论干扰源的分析

File的创建功能

统一认证

独立站

51单片机

BH1750

iwebsec

Cookie

android布局

IO-Link

建造者模式

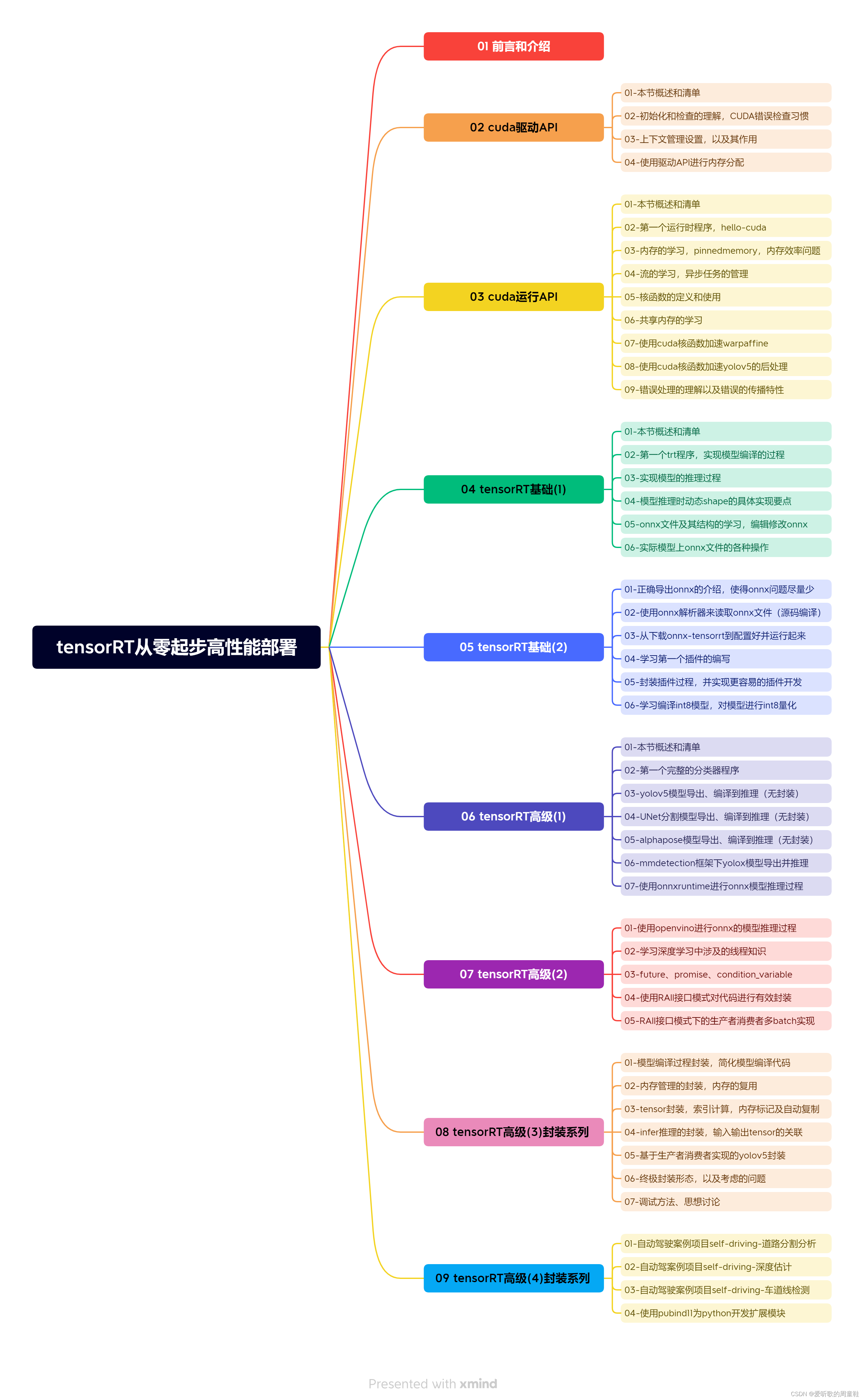

tensorrt

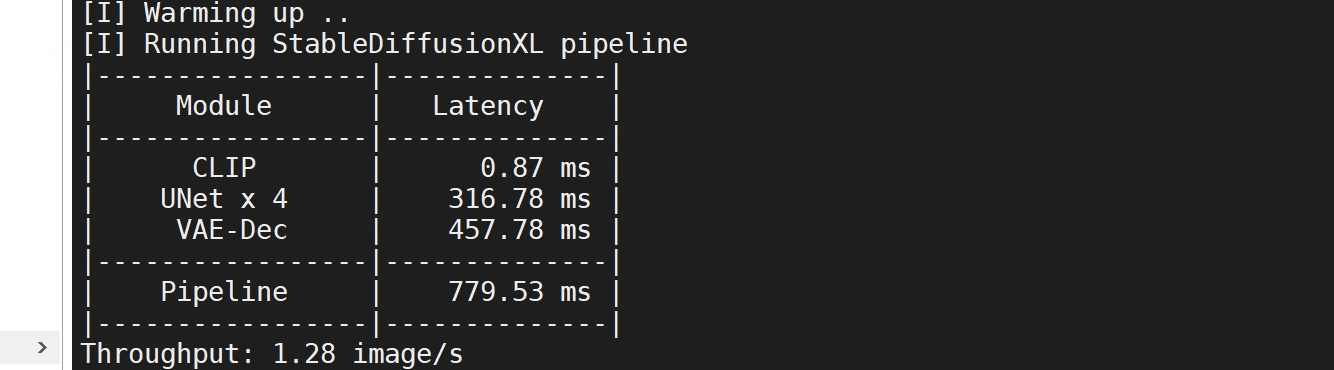

2024/4/11 17:32:24(含代码)利用NVIDIA Triton加速Stable Diffusion XL推理速度

在 NVIDIA AI 推理平台上使用 Stable Diffusion XL 生成令人惊叹的图像 扩散模型正在改变跨行业的创意工作流程。 这些模型通过去噪扩散技术迭代地将随机噪声塑造成人工智能生成的艺术,从而基于简单的文本或图像输入生成令人惊叹的图像。 这可以应用于许多企业用例&…

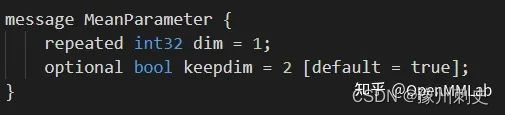

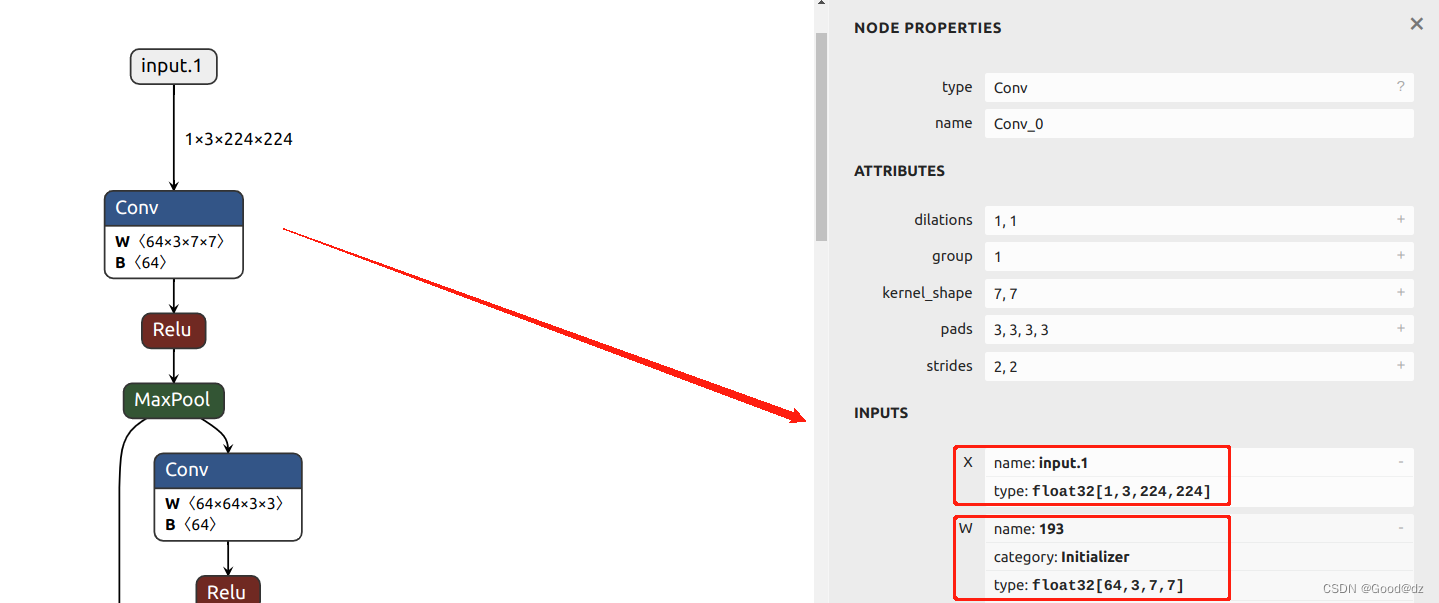

模型部署 - onnx的导出和分析 - onnx 的架构和 onnx helper 的使用 - 学习记录

onnx 的架构和 onnx helper 的使用 简介一、onnx 的架构二、onnx 实践2.1、 create - linear.onnx2.1.1、要点一:创建节点2.1.2、要点二:创建张量2.1.3、要点三:创建图 2.2、 create - onnx.convnet2.3、使用 onnx helper 导出的基本流程总结…

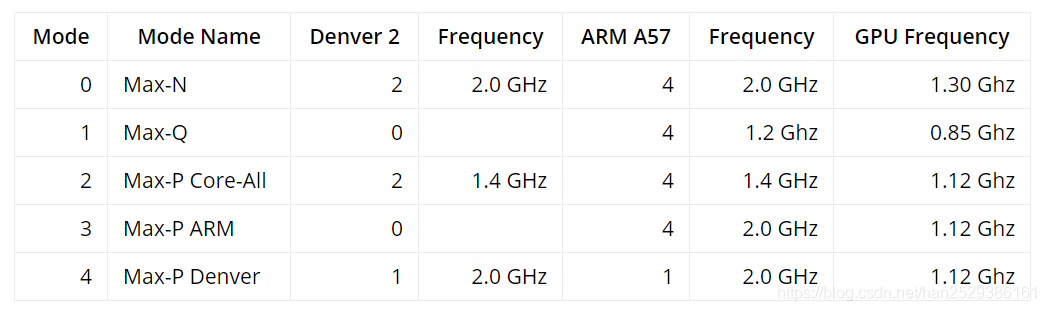

jetson Orin nano 部署(一)

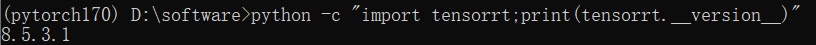

jetson Orin nano上安装VScode 和 anconda环境配置,在anaconda中安装pytorch、torchvision、tensorrt 安装VScode下载VScode安装VScode 安装anaconda安装pytorh和torchvision,tensorrttrtexec的问题 安装VScode

下载VScode

点击VScode下载链接…

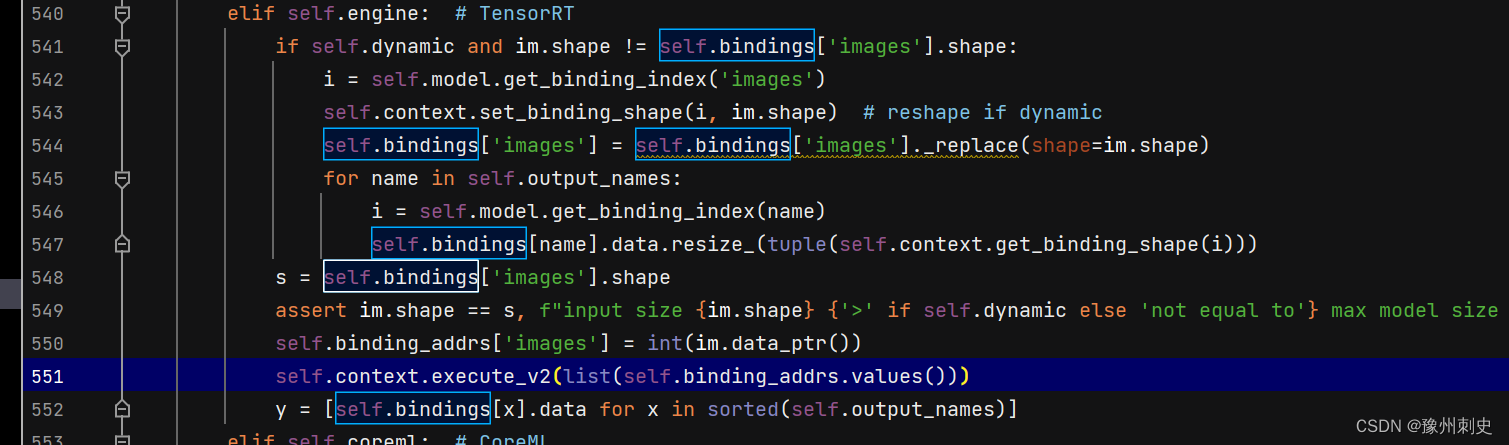

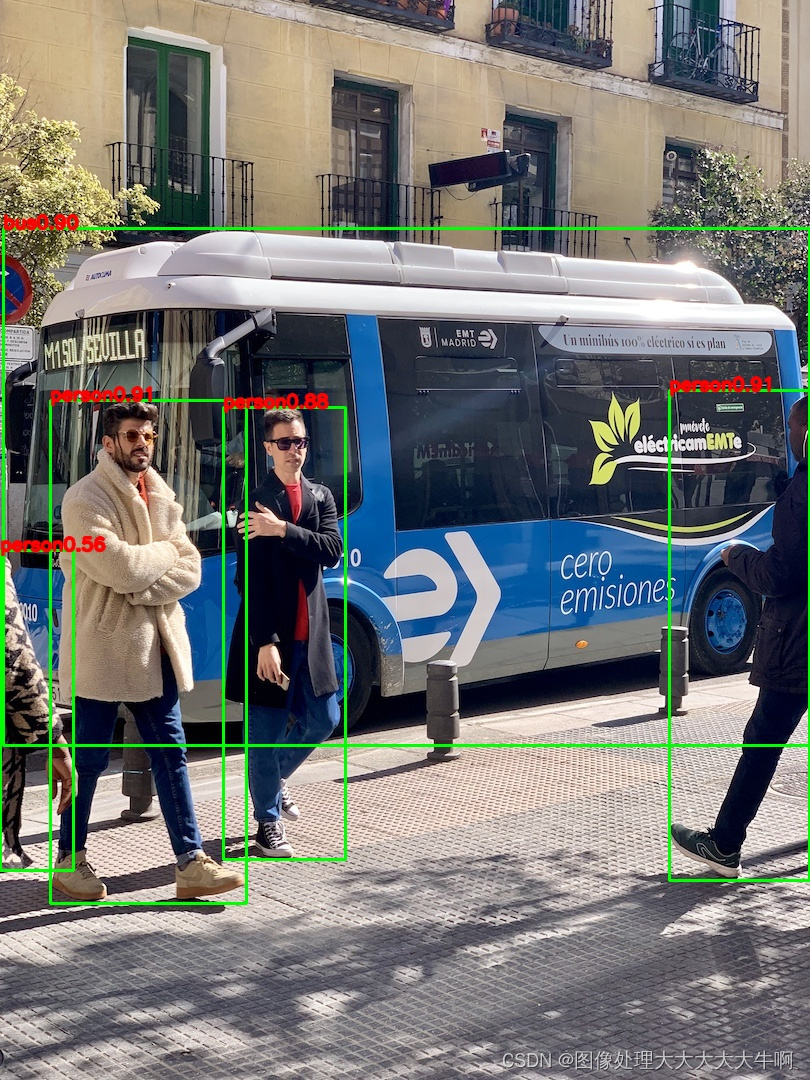

YOLOv8-Seg推理详解及部署实现

目录 前言一、YOLOv8-Seg推理(Python)1. YOLOv8-Seg预测2. YOLOv8-Seg预处理3. YOLOv8-Seg后处理4. YOLOv8-Seg推理 二、YOLOv8-Seg推理(C)1. ONNX导出2. YOLOv8-Seg预处理3. YOLOv8-Seg后处理4. YOLOv8推理 三、YOLOv8-Seg部署1. 源码下载2. 环境配置2.1 配置CMakeLists.txt2.…

在windows和linux上玩转Tensorrt

为避免重复,一些安装内容我直接贴其他大佬的帖子了,我是按照他们的步骤来操作的,趟过一遍,没有问题。 本篇着重在tensort在Cmakelist中如何配置,以及如何配置编译动/静态库,比较基础,也是想做个…

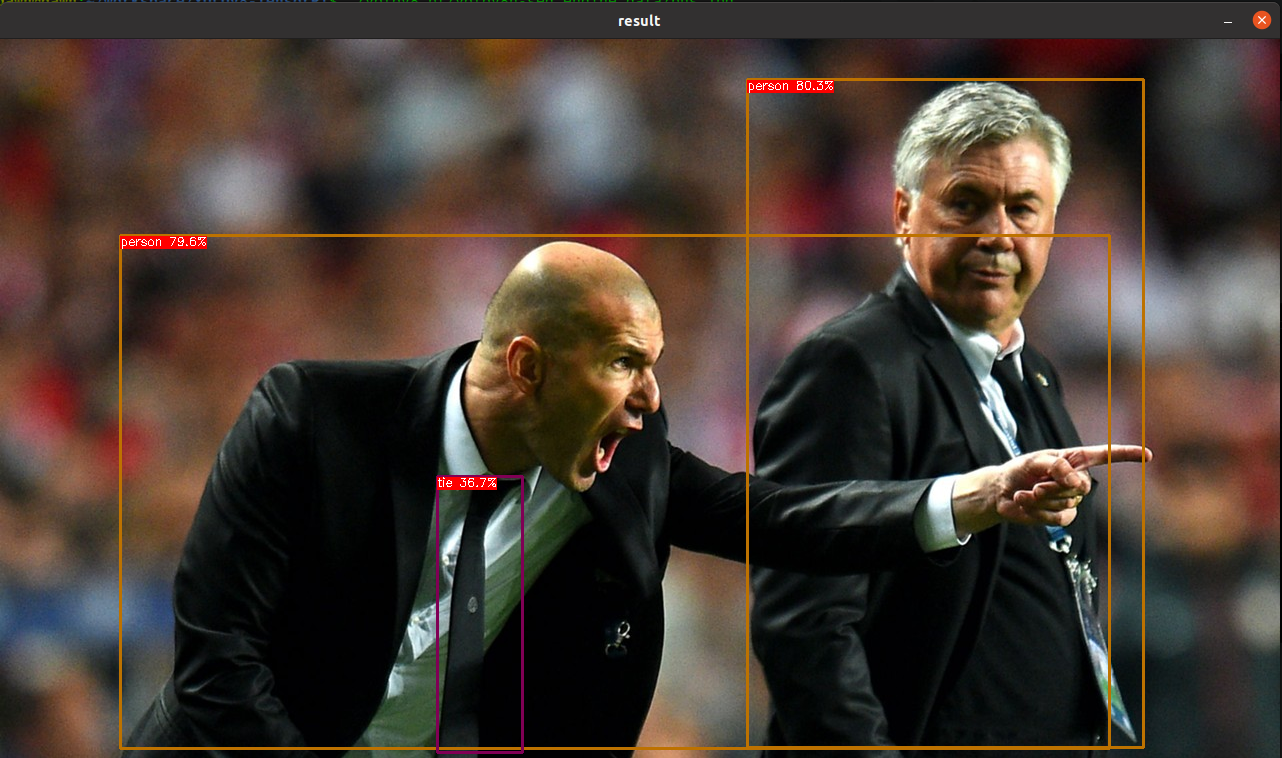

YOLOv8-Pose推理详解及部署实现

目录 前言一、YOLOv8-Pose推理(Python)1. YOLOv8-Pose预测2. YOLOv8-Pose预处理3. YOLOv8-Pose后处理4. YOLOv8-Pose推理 二、YOLOv8-Pose推理(C)1. ONNX导出2. YOLOv8-Pose预处理3. YOLOv8-Pose后处理4. YOLOv8-Pose推理 三、YOLOv8-Pose部署1. 源码下载2. 环境配置2.1 配置CM…

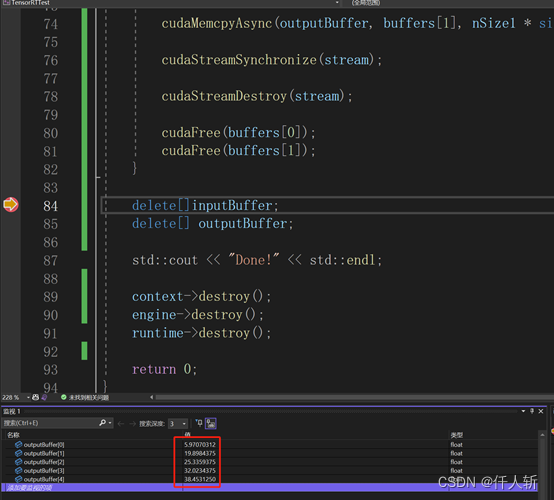

c++通过tensorRT调用模型进行推理

模型来源: 算法工程师训练得到的onnx模型

c对模型的转换: 拿到onnx模型后,通过tensorRT将onnx模型转换为对应的engine模型,注意:训练用的tensorRT版本和c调用的tensorRT版本必须一致。

如何转换:

算法工…

ubuntu系统安装tensorRT-8.6.1版本(2023-8月最新版)

目录 前言pip安装可能出现的报错: tar.gz安装 前言

看了无数教程和b站视频,啊啊啊啊啊啊啊啊啊啊啊tensorRT要我狗命啊。我要写全网tensorRT最全的博客!!! 总体来说成功安装方式有两种,pip安装和tar.gz安装(其实官网安装方式居多…

使用TensorRT对Yolov5进行部署【基于Python】

如果还未配置TensorRT,请看这篇博文:Win11下TensorRT环境部署

这里使用TensorRT对Yolov5进行部署流程比较固定:先将pt模型转换为onnx,再将onnx模型转为engine,所以在执行export.py时要将onnx、engine给到include。

P…

9.1.tensorRT高级(4)封装系列-自动驾驶案例项目self-driving-道路分割分析

目录 前言1. 道路分割总结 前言 杜老师推出的 tensorRT从零起步高性能部署 课程,之前有看过一遍,但是没有做笔记,很多东西也忘了。这次重新撸一遍,顺便记记笔记。 本次课程学习 tensorRT 高级-自动驾驶案例项目self-driving-道路分…

Stable Diffusion教程——使用TensorRT GPU加速提升Stable Diffusion出图速度

概述

Diffusion 模型在生成图像时最大的瓶颈是速度过慢的问题。为了解决这个问题,Stable Diffusion 采用了多种方式来加速图像生成,使得实时图像生成成为可能。最核心的加速是Stable Diffusion 使用了编码器将图像从原始的 3512512 大小转换为更小的 46…

TensorRT开发踩坑笔记

bindding 数据类型部一致

某个输出的数据类型是int, 忽略了,一直当作是float解析,导致错误。

虽然int 和 float 占用内存大小是一样的,但是解析方式错误,导致最终的错误,看来对每个bingding做输入输出校验,…

在Jetson nano上部署PaddleSeg

环境前提

jetson nano已经安装好图像化Linux系统,大家在网上找教程随便装一个自己喜欢的。 配置好python和pip

开始

Paddle Inference 是飞桨的原生推理库, 作用于服务器端和云端,提供高性能的推理能力,在使用之前,…

TensorRT加速推理入门-1:Pytorch转ONNX

这篇文章,用于记录将TransReID的pytorch模型转换为onnx的学习过程,期间参考和学习了许多大佬编写的博客,在参考文章这一章节中都已列出,非常感谢。 1. 在pytorch下使用ONNX主要步骤

1.1. 环境准备

安装onnxruntime包 安装教程可…

『模型部署』神经网络模型部署[运行时|指令执行|处理器架构|TensorRT]

『模型部署』神经网络模型部署[运行时|指令执行|处理器架构|TensorRT] 文章目录 一. 神经网络部署1.1. 程序语言运行时(Runtime)1.2. C++运行时(Runtime) 与 C++ 标准1.3. 神经网络运行时(Runtime)1.4. 神经网络表示1.5. 神经网络部署&例子二. TensorRT教程2.1. 前置条件-计…

8.5.tensorRT高级(3)封装系列-基于生产者消费者实现的yolov5封装

目录 前言1. yolov5封装总结 前言 杜老师推出的 tensorRT从零起步高性能部署 课程,之前有看过一遍,但是没有做笔记,很多东西也忘了。这次重新撸一遍,顺便记记笔记。 本次课程学习 tensorRT 高级-基于生产者消费者实现的yolov5封装…

8.1.tensorRT高级(3)封装系列-模型编译过程封装,简化模型编译代码

目录 前言1. 模型编译过程封装2. 问答环节总结 前言 杜老师推出的 tensorRT从零起步高性能部署 课程,之前有看过一遍,但是没有做笔记,很多东西也忘了。这次重新撸一遍,顺便记记笔记。 本次课程学习 tensorRT 高级-模型编译过程封装…

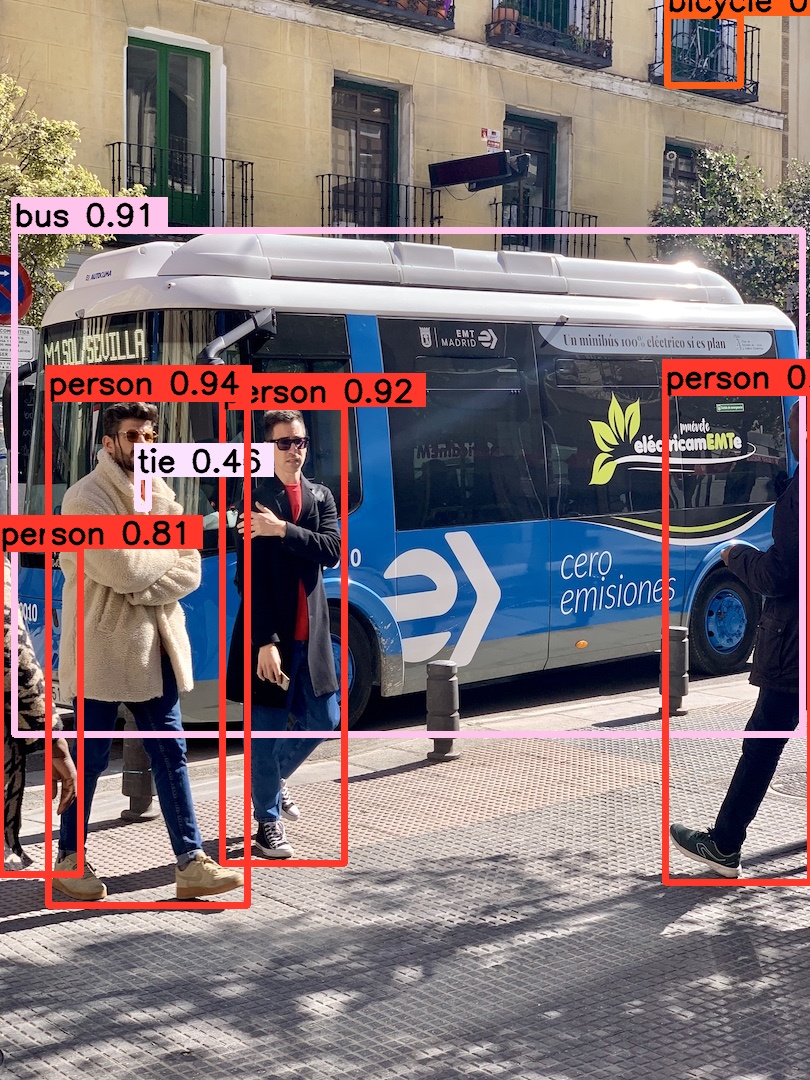

YoloV5+TensorRT封装|C#调用dll实现V5+TRT目标检测

在目标检测得领域中,yolo系列无疑是最强得目标检测框架,而其中得yolov5更是扛把子得存在,虽然有着众多的yolo系列版本,但是在工业领域中yolov5还是用的最多,yolov5 yyds,,,先奉献上我…

7.5.tensorRT高级(2)-RAII接口模式下的生产者消费者多batch实现

目录 前言1. RAII接口模式封装生产者消费者2. 问答环节总结 前言 杜老师推出的 tensorRT从零起步高性能部署 课程,之前有看过一遍,但是没有做笔记,很多东西也忘了。这次重新撸一遍,顺便记记笔记。 本次课程学习 tensorRT 高级-RAI…

PointPillars->ONNX->TensorRT加速学习记录

PointPillars->ONNX->TensorRT加速学习记录

【模型加速】PointPillars模型TensorRT加速实验(1)【模型加速】PointPillars模型TensorRT加速实验(2)【模型加速】PointPillars模型TensorRT加速实验(3)【模型加速】PointPillars模型TensorRT加速实验(4)【模型加速】PointPil…

TensorRT-Plugin编写

1 TensorRT Plugin 初识

实现原生不支持的算子 是 Plugin 最基础的能力,当然它还可以做更多事情,比如手动融合 TensorRT 没有自动融合的层 或 块。总结来说,TensorRT Plugin 的功能主要有以下几点: (1) 实现 TensorRT 原生不支持…

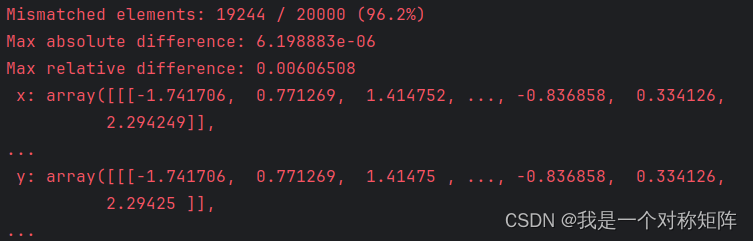

Cap2:Pytorch转TensorRT(上:Pytorch->ONNX)

文章目录 1、pytorch导出onnx模型2、使用onnxruntime推理onnx模型3、精度对齐4、总结 深度学习框架种类繁多,想实现任意框架之间的模型转换是一件困难的事情。但现在有一个中间格式ONNX,任何框架模型都支持转为ONNX,然后也支持从ONNX转为自身…

Ultralytics(YoloV8)开发环境配置,训练,模型转换,部署全流程测试记录

关键词:windows docker tensorRT Ultralytics YoloV8

配置开发环境的方法:

1.Windows的虚拟机上配置:

Python3.10 使用Ultralytics 可以得到pt onnx,但无法转为engine,找不到GPU,手动转也不行࿰…

YOLOv5 tensorRT C++代码详解之engine的读取

在tensorRT中,engine模型是对yolov5序列化后的结果。在推理的时候需要进行反序列化才能进行推理。那么第一步就是读取engine文件。 ifstream介绍

engine文件的读取需要用到ifstream,需要导入头文件#include <iostream>,#include <f…

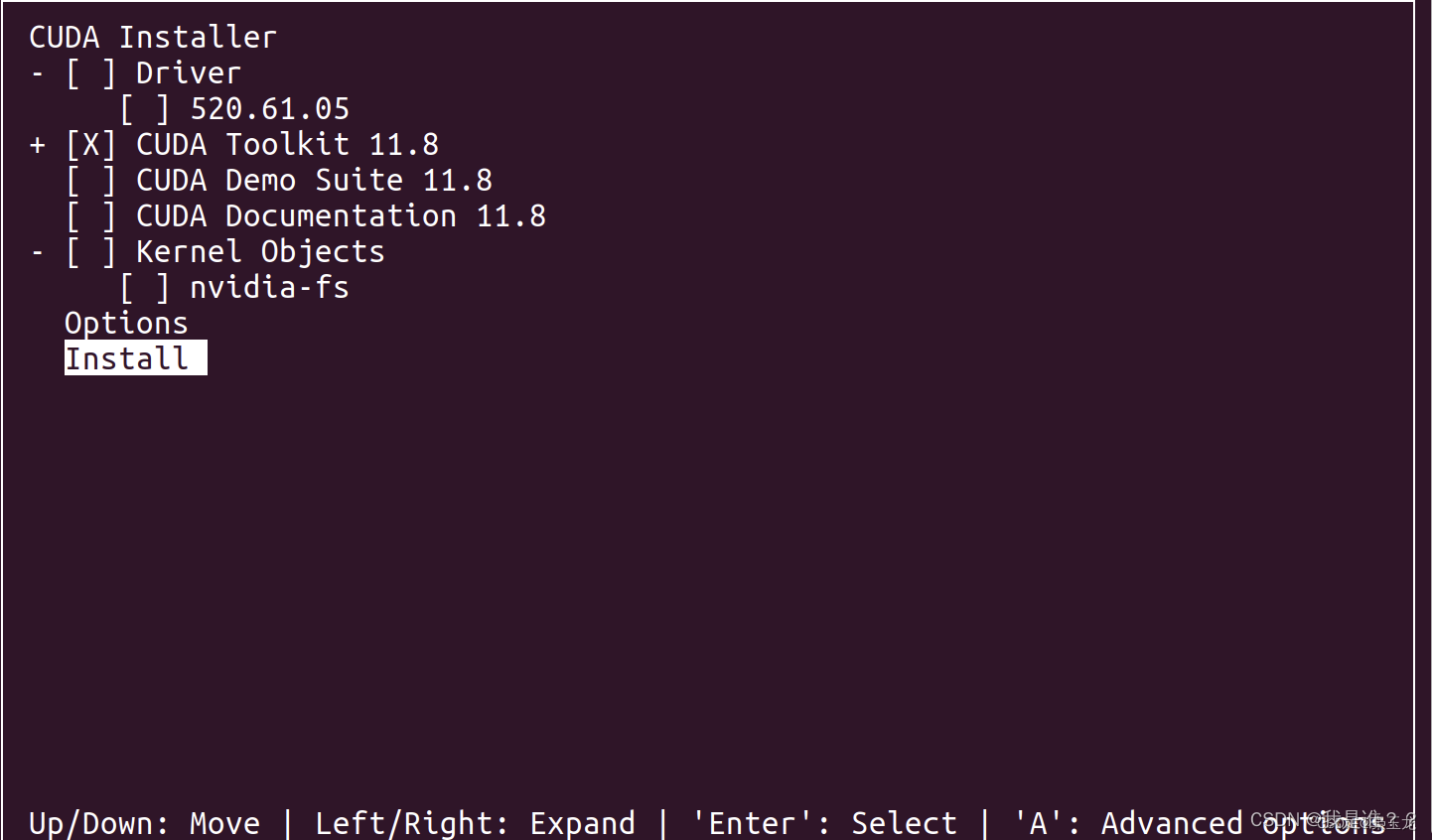

ubuntu 20.04 + cuda-11.8 + cudnn-8.6+TensorRT-8.6

1、装显卡驱动

ubuntu20.04 cuda10.0 cudnn7.6.4_我是谁??的博客-CSDN博客

查看支持的驱动版本:

查看本机显卡能够配置的驱动信息

luhost:/usr/local$ ubuntu-drivers devices/sys/devices/pci0000:00/0000:00:01.0/0000:01:00.0

moda…

Jetson Tx2上运行的代码分析

代码来自于https://github.com/dusty-nv/jetson-inference

运行:

下载代码->按照代码的编译过程cmake->下载CmakePreBuild.sh中网址的内容(这些是网络的model),然后放到指定的位置,就可以运行程序实例

使用cgdb分析代码 …

RealESRGAN系列网络 C++Win10Tensorrt 部署教程

前一篇文章对 RealESRGAN_x4, RealESRGAN_x2以及AnimeVideo-v3成功部署,尤其是将RealESRGAN_x4的推理时间从原先python的20s以上提高到2s以内。尽管如此,仍面临以下问题: RealESRGAN_x4推理时间仍较长,无法在工业界实时应用;AnimeVideo-v3速度足够快,但其主要是针对动漫…

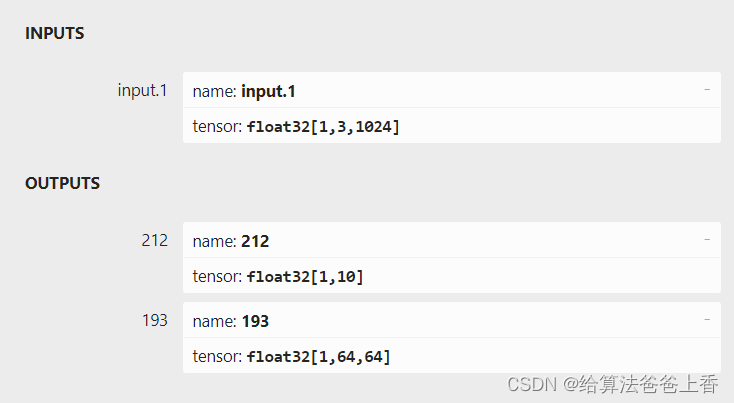

pointnet C++推理部署--tensorrt框架

classification 如上图所示,由于直接export出的onnx文件有两个输出节点,不方便处理,所以编写脚本删除不需要的输出节点193:

import onnxonnx_model onnx.load("cls.onnx")

graph onnx_model.graphinputs graph.inpu…

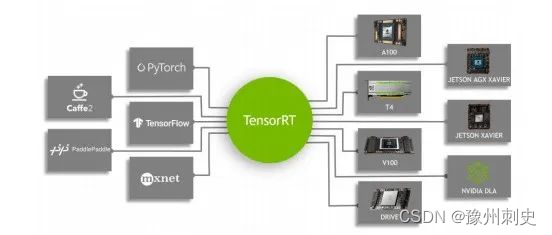

TensorRT加速的原因:量化+网络结构优化

文章目录 1. TensorRT 简介2. TensorRT 加速的原理量化网络结构优化 3. TensorRT 的 工作流程TensorRT引擎的构建:BuildTensorRT引擎的推理:Infer 1. TensorRT 简介

TensorRT可以帮助你把训练好的AI模型,部署到边端Nvidia的设备,…

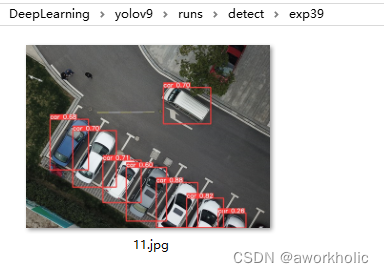

opencv dnn模块 示例(25) 目标检测 object_detection 之 yolov9

文章目录 1、YOLOv9 介绍2、测试2.1、官方Python测试2.1.1、正确的脚本2.2、Opencv dnn测试2.2.1、导出onnx模型2.2.2、c测试代码 2.3、测试统计 3、自定义数据及训练3.1、准备工作3.2、训练3.3、模型重参数化 1、YOLOv9 介绍

YOLOv9 是 YOLOv7 研究团队推出的最新目标检测网络…

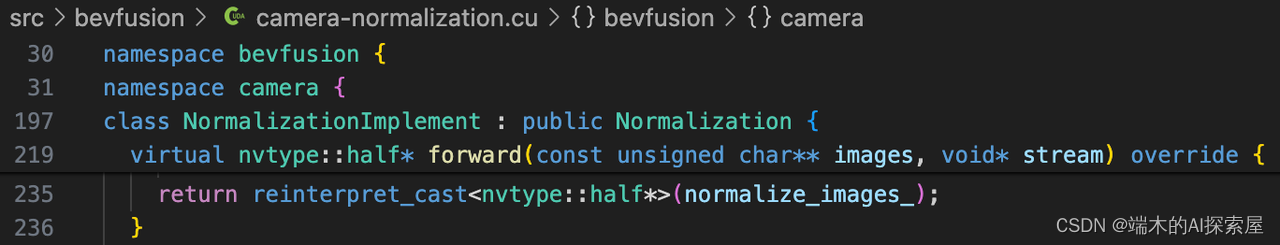

MIT-BEVFusion系列九--CUDA-BEVFusion部署6 前向推理的数据加载与图像预处理

目录 加载图像数据加载点云数据模型推理并计时预热操作模型推理检查点云输入数据量打印信息中CopyLidar部分的计算和耗时打印信息中ImageNrom图像预处理部分计算和耗时 该系列文章与qwe、Dorothea一同创作,喜欢的话不妨点个赞。 接上面的文章,目光聚焦回…

从零开始 TensorRT(7)C++ 篇:解析 ONNX

前言

学习资料: B站视频配套代码 cookbook

示例

参考源码:cookbook → 04-BuildEngineByONNXParser → pyTorch-ONNX-TensorRT

源码

C 代码量较多,已上传 GitHub OpenCV 安装:

apt install libopencv-dev(1&…

yolov8+tensorRT加速推理+部署-姿态识别-实力分割-目标检测

入门指南

这个项目演示了如何使用 TensorRT C++ API 运行 YoloV8 的 GPU 推理。它使用了我的另一个项目 tensorrt-cpp-api 在后台运行推理,因此请确保您熟悉该项目。

先决条件 在 Ubuntu 20.04 上测试并工作安装 CUDA,说明在这里。 推荐 >= 11.8安装 cuDNN,说明在这里。…

8.3.tensorRT高级(3)封装系列-tensor封装,索引计算,内存标记及自动复制

目录 前言1. Tensor封装总结 前言 杜老师推出的 tensorRT从零起步高性能部署 课程,之前有看过一遍,但是没有做笔记,很多东西也忘了。这次重新撸一遍,顺便记记笔记。 本次课程学习 tensorRT 高级-tensor封装,索引计算&a…

TensorRT/samples/common/logger.h,logger.cpp,logging.h源碼研讀

TensorRT/samples/common/logger.h,logger.cpp,logging.h源碼研讀前言logger.hlogger.cpplogging.hexternlist initializationusingmember initializer listmove constructortime_t, tm多重繼承的順序(純)虛擬函數nested classfriend classopaque handle…

使用TensorRT-LLM进行高性能推理

LLM的火爆之后,英伟达(NVIDIA)也发布了其相关的推理加速引擎TensorRT-LLM。TensorRT是nvidia家的一款高性能深度学习推理SDK。此SDK包含深度学习推理优化器和运行环境,可为深度学习推理应用提供低延迟和高吞吐量。而TensorRT-LLM是在TensorRT基础上针对大模型进一步…

SpireCV如何利用TensorRT加速?

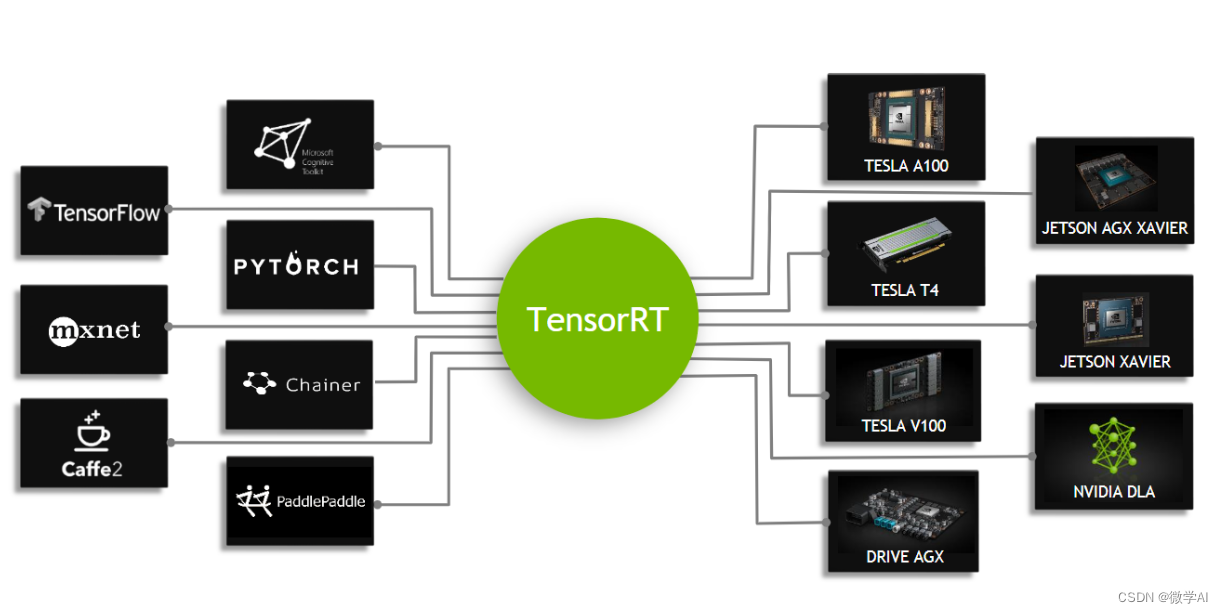

TensorRT简介

TensorRT是NVIDIA推出的一款高性能的深度学习推理引擎(C库)。相比于一般的深度学习框架,在GPU模式下其可提供36X的加速,极大提高了深度学习模型在边缘设备上的推断速度,以满足无人机、无人车等无人系统的快速视觉检测场景。 Te…

CUDA和TensorRT入门

CUDA

官方教程:CUDA C Programming Guide (nvidia.com)

一、基础知识

首先看一下显卡、GPU、和CUDA的关系介绍:

显卡、GPU和CUDA简介_吴一奇的博客-CSDN博客

延迟:一条指令返回的时间间隔;

吞吐量:单位时间内处理…

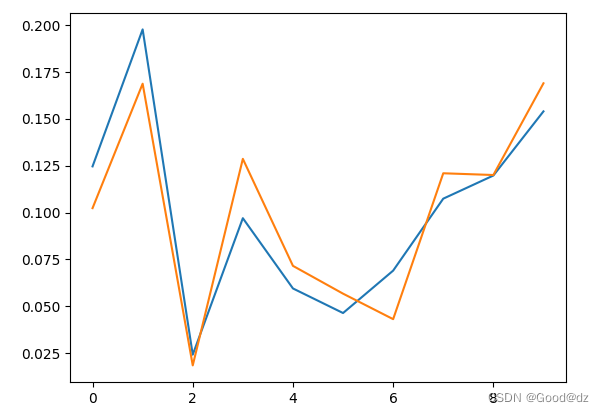

9.3.tensorRT高级(4)封装系列-自动驾驶案例项目self-driving-车道线检测

目录 前言1. 车道线检测总结 前言 杜老师推出的 tensorRT从零起步高性能部署 课程,之前有看过一遍,但是没有做笔记,很多东西也忘了。这次重新撸一遍,顺便记记笔记。 本次课程学习 tensorRT 高级-自动驾驶案例项目self-driving-车道…

tensorrt: pycuda, onnx, onnxruntime, tensorrt,torch-tensorrt 安装

文章目录 tensorrt: pycuda, onnx, onnxruntime, tensorrt,torch-tensorrt 安装1.深度学习模型部署综述(ONNX/NCNN/OpenVINO/TensorRT)2.安装tensorrt相关 tensorrt: pycuda, onnx, onnxruntime, tensorrt,torch-tensorrt 安装

pytorch: python

libtor…

ubuntu18.04安装tensorRT8.2实操

文章目录 一、安装pycuda二、安装TensorRT 一、安装pycuda

按照参考文档几个命令安装,但会有个问题。如果是容器中安装注意要映射nvcc,最好把整个路径映射过来/usr/local/bin;

然后可能还会出现src/cpp/cuda.hpp:14:10: fatal error: cuda.…

Yolov5 (v6.2) 使用自己的数据训练分类模型 基于ONNX TensorRT转换

前言

之前文章已经讲过yolov5模型的训练,这一篇将说一下分类模型训练流程。 https://blog.csdn.net/qq_45066628/article/details/129470290

新版本简介

YOLOv5官方发布了v6.2版本,v6.2版本支持分类模型训练、验证、预测和导出;v6.2版本的…

9.2.tensorRT高级(4)封装系列-自动驾驶案例项目self-driving-深度估计

目录 前言1. 深度估计总结 前言 杜老师推出的 tensorRT从零起步高性能部署 课程,之前有看过一遍,但是没有做笔记,很多东西也忘了。这次重新撸一遍,顺便记记笔记。 本次课程学习 tensorRT 高级-自动驾驶案例项目self-driving-深度估…

机器学习笔记 - windows基于TensorRT的UNet推理部署

一、TensorRT简介 NVIDIA TensorRT是一个用于高性能深度学习推理的平台。TensorRT适用于使用CUDA平台的所有NVIDIA GPU。所以如果需要基于TensorRT部署,至少需要一个NVIDIA显卡,算力5.0以上,比Maxwell更新的架构,可以参考下表。

CUDA GPUs - Compute Capability | NVIDIA …

yolov8x-p2 实现 tensorrt 推理

简述

在最开始的yolov8提供的不同size的版本,包括n、s、m、l、x(模型规模依次增大,通过depth, width, max_channels控制大小),这些都是通过P3、P4和P5提取图片特征; 正常的yolov8对象检测模型输出层是P3、…

【深度学习】SDXL tensorRT 推理,Stable Diffusion 转onnx,转TensorRT

文章目录 sdxl 转 diffusers转onnx转TensorRT sdxl 转 diffusers

def convert_sdxl_to_diffusers(pretrained_ckpt_path, output_diffusers_path):import osos.environ["HF_ENDPOINT"] "https://hf-mirror.com" # 设置 HF 镜像源(国内用户使…

Python api构建tensorrt加速模型

一、创建TensorRT有以下几个步骤:

1.用TensorRT中network模块定义网络模型 2.调用TensorRT构建器从网络创建优化的运行时引擎 3.采用序列化和反序列化操作以便在运行时快速重建 4.将数据喂入engine中进行推理

二、Python api和C api在实现网络加速有什么区别&…

极智开发 | 解读英伟达软件生态 深度学习推理引擎TensorRT

欢迎关注我的公众号 [极智视界],获取我的更多经验分享

大家好,我是极智视界,本文来介绍一下 解读英伟达软件生态 深度学习推理引擎TensorRT。 邀您加入我的知识星球「极智视界」,星球内有超多好玩的项目实战源码下载,链接:https://t.zsxq.com/0aiNxERDq TensorRT 对于很…

Tensorrt8.6.1安装

环境配置:Tensorrt8.6.1 ,cuda11.6, cudnn8.6.0, torch1.13.1cu116, torchvision0.14.1cu116 1.先把cuda11.6, cudnn8.6.0, torch1.13.1cu116, torchvision0.14.1cu116这几个安装完之后

2.下载Tensorrt8.6.1,复制移动以下文件

将include中头…

TensorRT部署YOLOv5(05)—图像推理

在上一篇文章中,对构建TensorRT引擎进行了介绍,本文将详细介绍如何使用Python API通过TensorRT引擎加速,实现单幅图像的推断

Workflow

单幅图像的推理过程大致如下 读入图像文件,并进行预处理 加载TensorRT引擎文件并进行反序列化,创建执行上下文context 根据引擎申请输…

yolov8量化部署(基于openvino和tensorrt)

yolov8 openvino量化部署

环境配置:

pip install ultralytics && pip install openvino-dev将pytorch模型转为openvino模型:

from ultralytics import YOLO# Load a model

model YOLO("./yolov8n.pt") # load an official model# Export the…

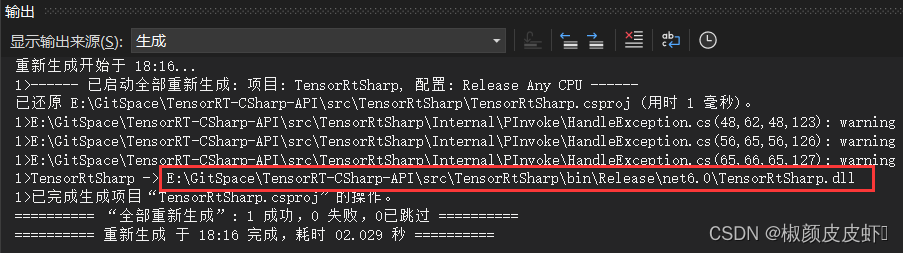

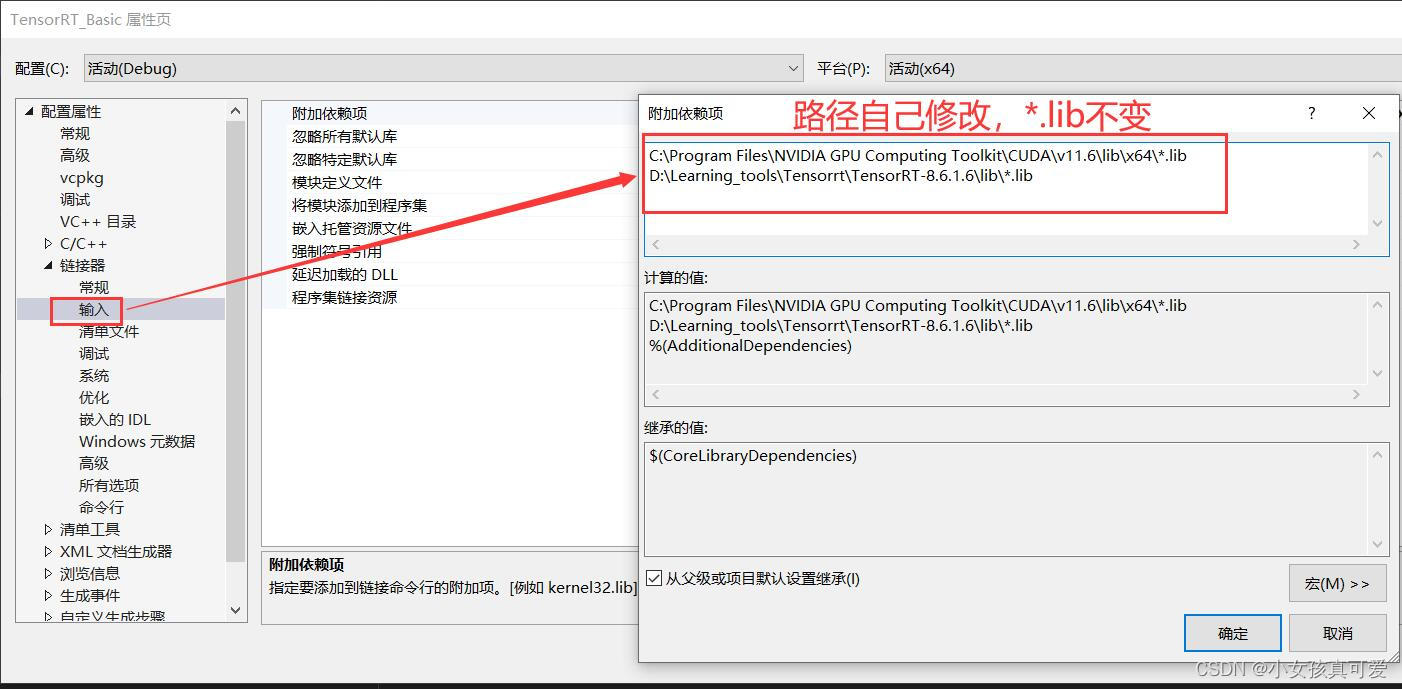

【TensorRT】TensorRT C# API 项目介绍:基于C#与TensorRT部署深度学习模型(上篇)

文章目录 1. 项目介绍2. 接口介绍3. 安装流程3.1 TensorRT安装3.2 下载项目源码3.3 配置C项目第一步:设置项目输出类型第二步:设置包含目录第三步:设置库目录第四步:设置附加依赖项第五步:设置预处理器第六步ÿ…

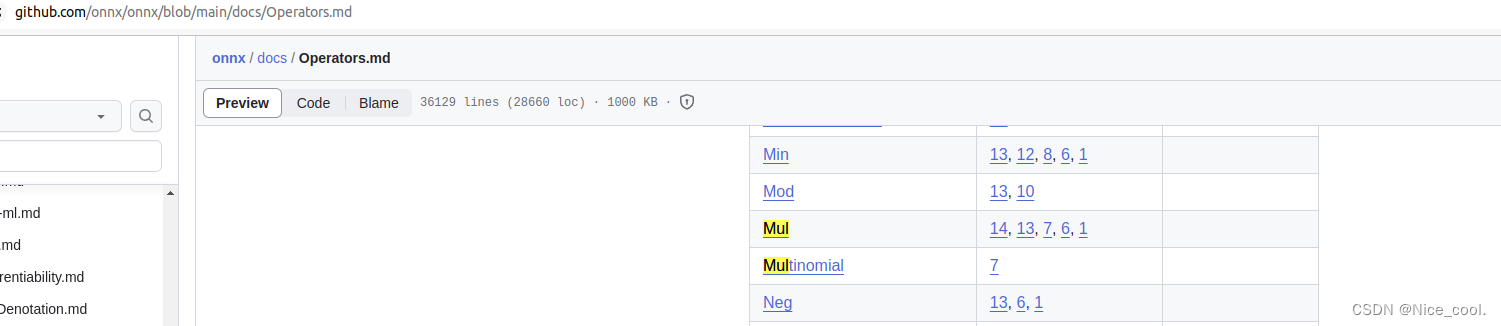

如何查看TensorRT默认支持的算子(operator)

TensorRT7.0支持的ONNX算子列表

https://github.com/onnx/onnx-tensorrt/blob/84b5be1d6fc03564f2c0dba85a2ee75bad242c2e/oper ators.md

OperatorSupported?RestrictionsAbsYAcosYAcoshYAddYAndYArgMaxYArgMinYAsinYAsinhYAtanYAtanhYAveragePoolY2D or 3D Pooling onlyBa…

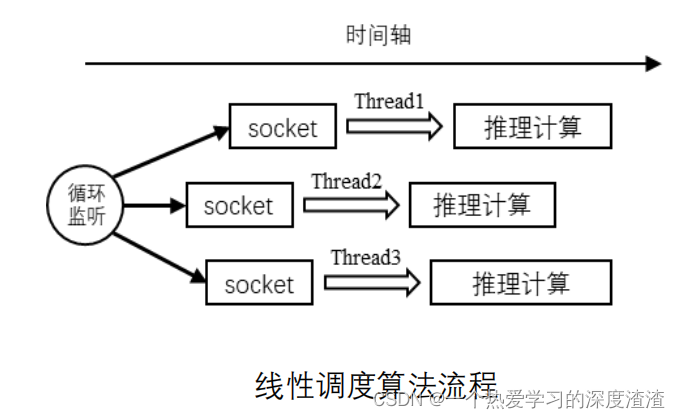

7.2.tensorRT高级(2)-学习深度学习中涉及的线程知识

目录 前言1. 多线程2. 问答环节2.1 线程启动相关问题2.2 线程启动函数参数相关问题 总结 前言 杜老师推出的 tensorRT从零起步高性能部署 课程,之前有看过一遍,但是没有做笔记,很多东西也忘了。这次重新撸一遍,顺便记记笔记。 本次…

tensorRT_Pro 项目实践

参考:https://github.com/shouxieai/tensorRT_Pro/blob/main/tutorial/README.zh-cn.md

前提:

https://www.cnblogs.com/odesey/p/17619218.html

https://www.cnblogs.com/odesey/p/17619240.html

ubuntu20.04opencv4.2cuda11.8cuDNN v8.9.0 (July 1…

TensorRt安装和命令行测试

1、选择TensorRt版本

安装tensorrt前,需要先了解自己的显卡算力、架构等,点击 算力列表链接 对号入座。 这里仅展示RTX和Titan系列,其他系列可在当前网页选择。

1.1、cuda版本

首先需要安装cuda,其版本并不是最新就好…

8.2.tensorRT高级(3)封装系列-内存管理的封装,内存的复用

目录 前言1. 内存管理封装2. 补充知识总结 前言 杜老师推出的 tensorRT从零起步高性能部署 课程,之前有看过一遍,但是没有做笔记,很多东西也忘了。这次重新撸一遍,顺便记记笔记。 本次课程学习 tensorRT 高级-内存管理的封装&…

YOLOv8推理详解及部署实现

目录 前言一、YOLOv8推理(Python)1. YOLOv8预测2. YOLOv8预处理3. YOLOv8后处理4. YOLOv8推理 二、YOLOv8推理(C)1. ONNX导出2. YOLOv8预处理3. YOLOv8后处理4. YOLOv8推理 三、YOLOv8部署1. 源码下载2. 环境配置2.1 配置CMakeLists.txt2.2 配置Makefile 3. ONNX导出4. 源码修改…

模型部署 - BevFusion - (1) - 思路总结

模型部署实践 - BevFusion 思路总结一、网络结构 - 总结1.1、代码1.2、网络流程图1.3、模块大致梳理 二、Onnx 的导出 -总体思路分析三、优化思路总结 学习 BevFusion 的部署,看了很多的资料,这篇博客进行总结和记录自己的实践

思路总结

对于一个模型我…

PyTorch训练,TensorRT部署的简要步骤(采用ONNX中转的方式)

1. 简述

使用PyTorch执行训练,使用TensorRT进行部署有很多种方法,比较常用的是基于INetworkDefinition进行每一层的自定义,这样一来,会反向促使研究者能够对真个网络的细节有更深的理解。

另一种相对简便的方式就是通过ONNX中间…

TensorRT是什么,有什么作用,如何使用

TensorRT 是由 NVIDIA 提供的一个高性能深度学习推理(inference)引擎。它专为生产环境中的部署而设计,用于提高在 NVIDIA GPU 上运行的深度学习模型的推理速度和效率。以下是关于 TensorRT 的详细介绍:

TensorRT 是 NVIDIA 推出的…

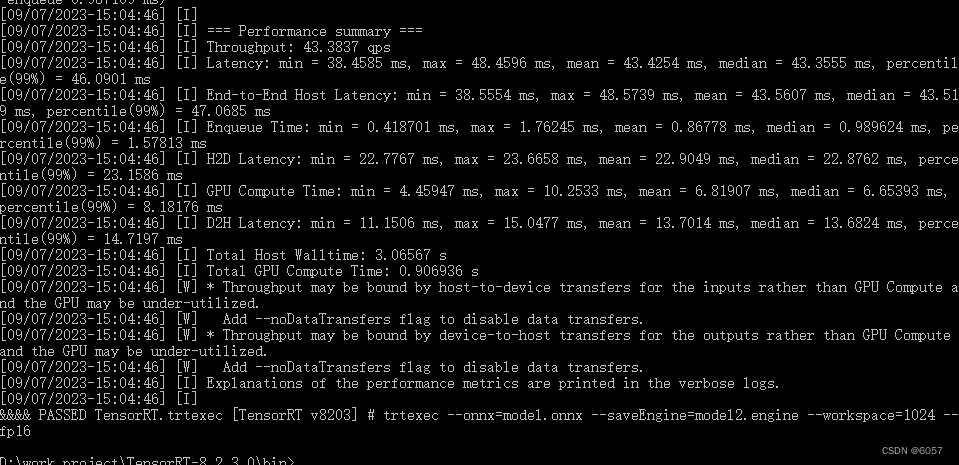

从零开始 TensorRT(4)命令行工具篇:trtexec 基本功能

前言

学习资料: TensorRT 源码示例 B站视频:TensorRT 教程 | 基于 8.6.1 版本 视频配套代码 cookbook

参考源码:cookbook → 07-Tool → trtexec 官方文档:trtexec

在 TensorRT 的安装目录 xxx/TensorRT-8.6.1.6/bin 下有命令行…

YOLOv8-Cls推理详解及部署实现

目录 前言一、YOLOv8-Cls推理(Python)1. YOLOv8-Cls预测2. YOLOv8-Cls预处理3. YOLOv8-Cls推理 二、YOLOv8-Cls推理(C)1. ONNX导出2. YOLOv8-Cls预处理3. YOLOv8-Cls推理 三、YOLOv8-Cls部署1. 源码下载2. 环境配置2.1 配置CMakeLists.txt2.2 配置Makefile 3. ONNX导出4. 源码修…

TensorRT 简单介绍

一、TensorRT

对于算法工程师来说,相信大家已经对TensorRT耳熟能详了,那么这个TensorRT是什么呢?

其实,TensorRT是一个可以在NVIDIA各种GPU硬件平台下运行的推理引擎,同时也是一个高性能的深度学习推理优化器&#x…

ubuntu20.04安装tensorRT流程梳理

目标:先跑demo,再学习源码

step1, 提前准备好CUDA环境

安装CUDA,cuDNN

注意,CUDA,cuDNN需要去官网下载.run和tar文件安装,否则在下面step4 make命令会报找不到cuda等的错误,具体安装教程网上…

TensorRT trtexec 学习笔记

trtexec 实现onnx转tensorrt

./trtexec --onnxtest.onnx --saveEnginetest.gie --verbose --dumpLayerInfo --dumpOutput --dumpProfile其中--verbose 打印log--dumpLayerInfo将每个layer的信息都打印出来--dumpOutput将每个输出都打印到终端上来--dumpProfile打印一些中间分析…

Tensorrt 自定义插件的调用顺序及过程

一个自定义插件需要实现两个类,分别继承于

class MyPluginDynamic : public IPluginV2DynamicEx

class MyPluginDynamicCreator : public IPluginCreator

然后使用

REGISTER_TENSORRT_PLUGIN(MyPluginDynamicCreator);

看其详细定义,也就是将这个插…

Tensorrt 实现 yolov5-cls 遇到的问题

yolov5-6.2增加了分类训练、验证、预测和导出(所有 11 种格式),还提供了 ImageNet 预训练的 YOLOv5m-cls、ResNet(18、34、50、101) 和 EfficientNet (b0-b3) 模型.

官方Git : https://github.com/ultralytics/yolov5

分类模型与…

TensorRT自定义插件的实现

对于比较新或者计算OP,tensorrt的响应并没有那么快,这个时候就需要我们自己实现自定义的插件,先开个题吧,后面整理一下代码,再帖上来,

不错的链接实现TensorRT自定义插件(plugin)自由! (qq.com…

TensorRT网络推理c++实现

前言:本文给出了yolov3-tiny网络TensorRT推理步骤实现的c代码,手动计算显存与内存的大小,计算yolo层输出框的位置。

demo函数:

/*--------------------------------输入预处理---------------------------------*/std::string i…

C++ TensorRT开发笔记

有用的链接 NVIDIA工程师的仓库

GitHub - zerollzeng/tiny-tensorrt: Deploy your model with TensorRT quickly. 快速使用TensorRT来部署模型

参考上述仓库的实现

Python成神之路 - xavier平台上YOLOV5的TensorRT加速

在GPU上尽量部要有内存相关的操作,比如slice…

TensorRT解析onnx模型

目录 TensorRT简介

ONNX模型部署详细步骤

1.解析onnx模型,并保存序列化推理引擎文件 TensorRT简介

TensorRT是nvidia公司针对nvidia显卡训练的模型在特定平台进行加速的推理优化库,是一个c库,仅支持推理,不支持训练;…

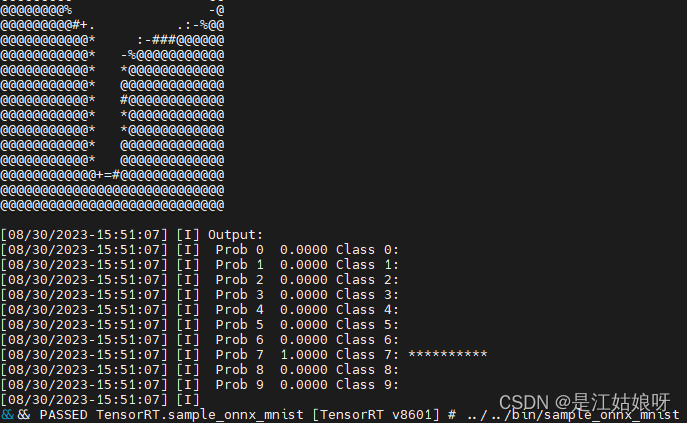

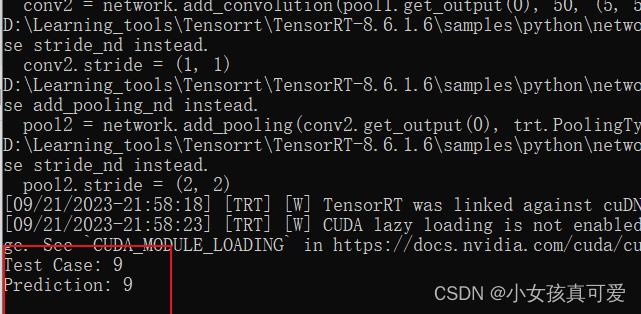

TensorRT推理手写数字分类(三)

系列文章目录

(一)使用pytorch搭建模型并训练 (二)将pth格式转为onnx格式 (三)onxx格式转为engine序列化文件并进行推理 文章目录 系列文章目录前言一、TensorRT是什么?二、如何通过onnx生成en…

YOLOv9推理详解及部署实现

目录 前言零、YOLOv9简介一、YOLOv9推理(Python)1. YOLOv9预测2. YOLOv9预处理3. YOLOv9后处理4. YOLOv9推理 二、YOLOv9推理(C)1. ONNX导出2. YOLOv9预处理3. YOLOv9后处理4. YOLOv9推理 三、YOLOv9部署1. 源码下载2. 环境配置2.1 配置CMakeLists.txt2.2 配置Makefile 3. ONNX…

1. TensorRT量化的定义及意义

前言

手写AI推出的全新TensorRT模型量化课程,链接:TensorRT下的模型量化。

课程大纲如下: 1. 量化的定义及意义

1.1 什么是量化?

定义

量化(Quantization)是指将高精度浮点数(如float32)表示为低精度整数(如int8)的过程&…

运行NVIDIA的TensorRT5.0.2.6的例子sample_uff_ssd遇到的坑

NVIDIA错误:ERROR: UFFParser: Graph error: Cycle graph detected ERROR: sample_uff_ssd: Fail to parse sample_uff_ssd: sampleUffSSD.cpp:540: int main(int, char**): Assertion tmpEngine ! nullptr failed.

tensorflow错误:ImportError: libcub…

yolov5量化部署(基于openvino和tensorrt)

yolov5 openvino量化部署

首先,下载YOLOv5源码,安装YOLOv5和OpenVINO的python依赖。

git clone https://github.com/ultralytics/yolov5.git

pip install -r requirements.txt && pip install openvino openvino-dev然后,通过YOLO…

YOLOv8-TensorRT C++ ubuntu部署

YOLOv8-TensorRT C ubuntu20.04部署

先要安装好显卡驱动、CUDA、CUDNN

以ubuntu20.04、显卡1650安装470版本的显卡驱动、11.3版本的CUDA及8.2版本的CUDNN为例

下载TensorRT

进入网站:

https://developer.nvidia.com/nvidia-tensorrt-8x-download

进行勾选下载…

深度学习技巧应用32-在YOLOv5模型上使用TensorRT进行加速的应用技巧

大家好,我是微学AI,今天给大家介绍一下深度学习技巧应用32-在YOLOv5模型上使用TensorRT进行加速的应用技巧,TensorRT是NVIDIA公司提供的一个深度学习推理(inference)优化器和运行时库。它专门为生产环境下的高性能深度学习推理提供优化支持。TensorRT可以加速深度学习模型…

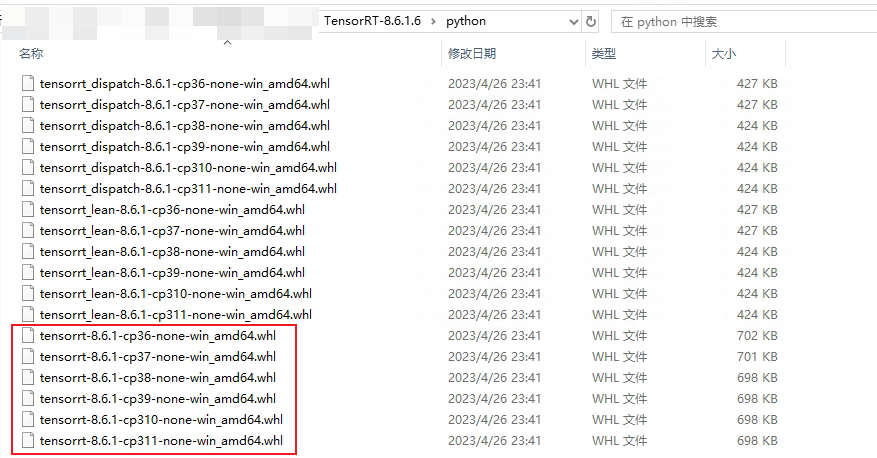

在windows安装python版本的tensorrt

文章目录 一、进入官网,下载tensorrt包二、下载后解压并把相应文件拷入对应cuda的文件夹2.1 拷贝头文件2.2 拷贝静态库2.3 拷贝动态库 三、安装whl文件四、验证 一、进入官网,下载tensorrt包

https://developer.nvidia.com/tensorrt-download

这里需要…

2.2 动态范围的常用计算方法

1. 动态范围的常用计算方法 动态范围(Dynamic Range)指的是输入数据中数值的范围,计算动态范围是为了确定量化时使用的比特位数(还是抽象😂)。个人理解:考虑到输入数据可能存在数据分布不均,即有些数据偏离过大。而过大的偏离值,会…

jetson nano csi摄像头 tensorrt 运行yolov8检测

jetson nano csi摄像头 tensorrt 运行yolov8检测 1. 在本地电脑训练环境下将onnx模型导出yolov8 导出onnx 模型使用onnxsim优化onnx 模型2. 在jetson nano下 转换到tensorrt模型配置好环境后 使用trtexec 生成engine使用python tensorrt 读取csi摄像头进行预测1. 在本地电脑训练…

visual studio2022使用tensorRT配置

只记录tensorRT在vs中使用时的配置,下载和安装的 文章主页自己寻找。

下载好TensorRT和对应的cuda之后,把tensorRT的锻炼了和lib文件复制粘贴到cuda对应的文件夹中,以方便调用。 完成之后打开vs新建一个tensorRT的项目,然后开始配…

八. 实战:CUDA-BEVFusion部署分析-环境搭建

目录 前言0. 简述1. CUDA-BEVFusion浅析2. CUDA-BEVFusion环境配置2.1 简述2.2 源码下载2.3 模型数据下载2.4 基础软件安装2.5 protobuf安装2.5.1 apt 方式安装2.5.2 源码方式安装 2.6 编译运行2.6.1 配置 environment.sh2.6.2 利用TensorRT构建模型2.6.3 编译运行程序 2.7 拓展…

8.6.tensorRT高级(3)封装系列-终极封装形态,以及考虑的问题

目录 前言1. 终极封装总结 前言 杜老师推出的 tensorRT从零起步高性能部署 课程,之前有看过一遍,但是没有做笔记,很多东西也忘了。这次重新撸一遍,顺便记记笔记。 本次课程学习 tensorRT 高级-终极封装形态,以及考虑的…

【深度学习】SDXL TensorRT Dockerfile Docker容器

文章目录 过程SDXL TensorRT构建SDXL TensorRT LCM 调度器过程

docker push kevinchina/deeplearning:cuda12.1torch2.1.1

FROM nvidia/cuda:12.1.1-cudnn8-devel-ubuntu22.04

ENV DEBIAN_FRONTEND=noninteractive# 安装基本软件包

RUN apt-get update && \apt-get u…

TensorRT转换onnx的Transpose算子遇到的奇怪问题

近来把一个模型导出为onnx并用onnx simplifier化简后转换为TensorRT engine遇到非常奇怪的问题,在我们的网络中有多个检测头时,转换出来的engine的推理效果是正常的,当网络中只有一个检测头时,转换出来的engine的推理效果奇差&…

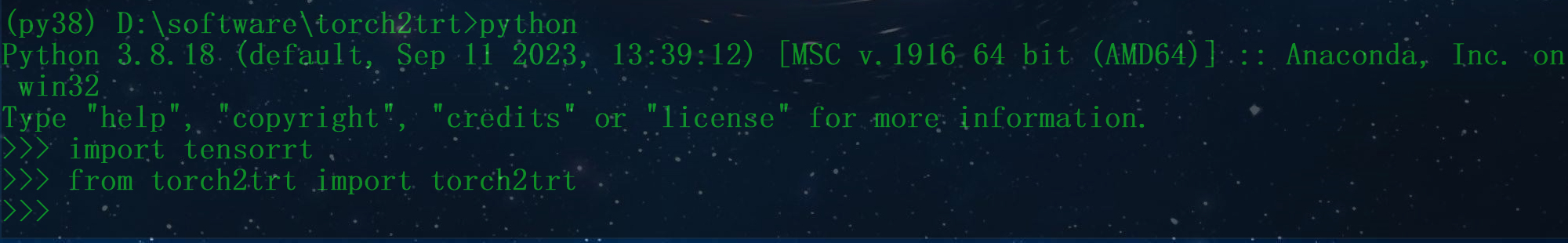

【Win10安装Tensorrt和torch2trt】

Win10安装Tensorrt和torch2trt 1 前言1.1 实验环境1.2 下载链接 2 具体安装2.1 TensorRT安装2.1.1 设置环境变量2.1.2 安装TensorRT资源包中的3个whl文件2.1.3 复制tensorrt的库到CUDA安装目录的指定文件夹 2.2 安装torch2trt2.3 验证是否安装成功 1 前言

1.1 实验环境

&…

Tensorrt导出engine文件加密(WindowsC++版)

扯皮的话:为了优化模型的inference,TensorRT会根据网络的定义执行优化包括特定平台的优化并生成inference engine。此过程被称为构建阶段,尤其是在嵌入式平台上会消耗大量的时间,因此,一个典型的应用程序只会被构建一次engine,然后将其序列化为plane file以供后续使用。需…

五、深入学习TensorRT,Developer Guide篇(四)

上一篇文章我们介绍了C的API,这篇文章我们主要针对的是Python的API,起始C和Python在整体流程上面基本一致,但是由于Python天然的简洁性和易用性,Python的API相对来讲还是比较简单的,我们一起来看一下吧。 文章目录 4.…

jetpack5.0.2 已经安装了 cudnn 和 tensorrt

在平台 jetson Xavier NX 中想使用 cudnn 和 tensorrt。然后自己下载了相应包并解压,拷贝,编译

安装 cudnn

1.下载对应包文件,例如:cudnn-linux-sbsa-8.4.1.50_cuda11.6-archive.tar.xz 2.解压,移动到解压目录&#…

YOLOv7+姿态估计Pose+tensort部署加速

YOLOv7-Pose

YOLOv7是一种高效的目标检测算法,用于实时物体检测。姿态估计Pose是一种用于识别和跟踪人体关键点的技术。TensorRT是一个针对深度学习推理任务进行加速的高性能推理引擎。

将YOLOv7和姿态估计Pose与TensorRT结合可以实现快速而准确的目标检测和姿态估…

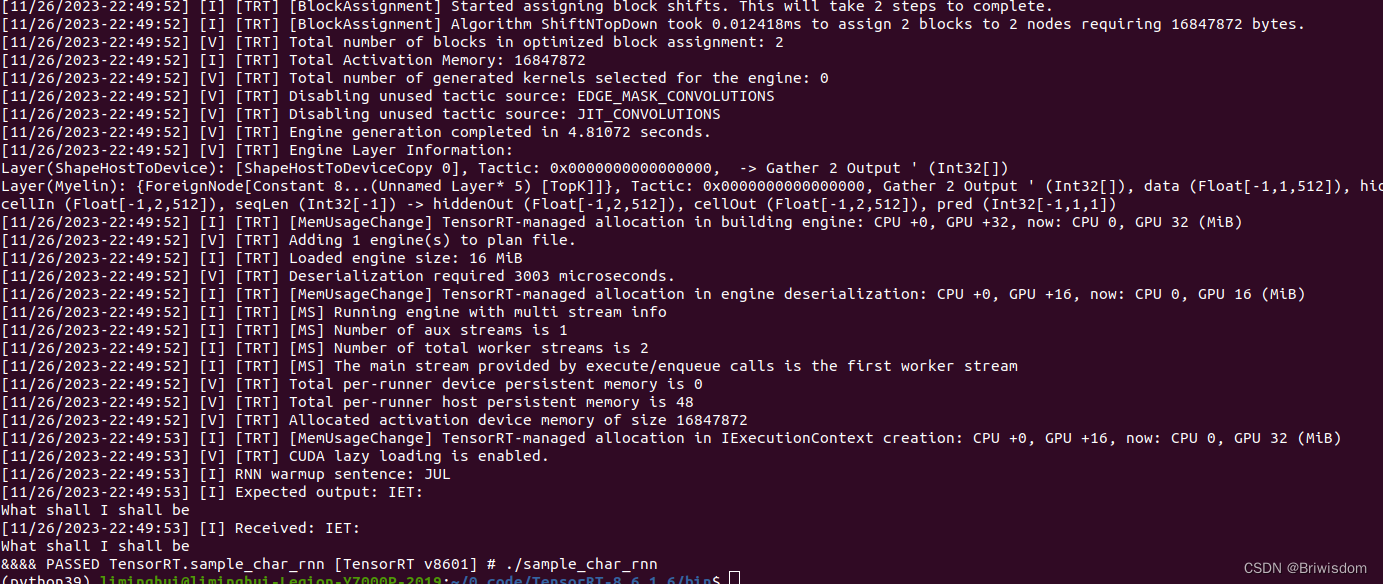

CUDA initialization failure with error: 999

ubuntu20.04,安装tensorRT, 执行example里面的./sample_char_rnn程序,测试时候报了如标题的一个错误,居然如下两行代码这样解决了,这两行命令好像是重新加载nvidia内核模块,有点玄学:

sudo rmmod nvidia_u…

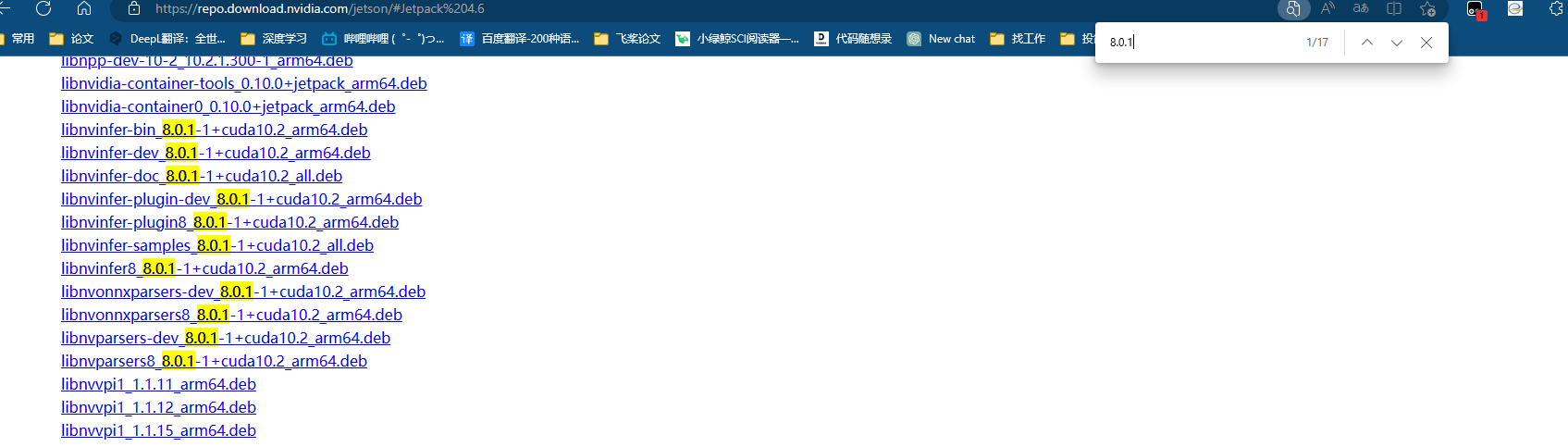

jetson填坑-单独安装cuda,cudnn,tensorrt任意适用版本

前言

jetson无法单独安装cuda,cudnn,tensorrt的解决方法,比下载SDK manager刷机安装简单好多倍 这个方法是直接下载deb包安装,deb包安装网站 https://repo.download.nvidia.com/jetson/

单独安装cuda

1

sudo apt-get install …

TensorRT优化和Jetson TX2的性能优化

文章目录1.TensorRT优化原理1) TensorRT目前支持的Layer Fusions2) 使用Batch和混合精度3) kernel auto-tuning2. 影响TensorRT优化的因素3. 如何最大化系统的性能(TX2)1.TensorRT优化原理 TensorRT加速DL Inference的能力来源于优化器和运行时ÿ…

【模型部署】TensorRT的安装与使用

文章目录1.TensorRT的安装1.1 cuda/cudnn以及虚拟环境的创建1.2 根据cuda版本安装相对应版本的tensorRT2. TensorRT的使用2.1 直接构建2.2 使用 Python API 构建2.3 使用 C API 构建2.4 IR 转换模型2.4.1 使用 Python API 转换2.4.2 使用 C API 转换2.5 模型推理2.5.1 使用 Pyt…

TensorRT优化原理和TensorRT Plguin总结

文章目录1. TensorRT优化原理2. TensorRT开发基本流程3. TensorRT Network Definition API4. TensorRT Plugin4.1 实现plugin4.2 编译plugin.so动态库4.3 在TensorRT中加载plugin5. plugin实例1. TensorRT优化原理 TensorRT加速DL Inference的能力来源于optimizer和runtime。其…

TensorRTTriton学习笔记(一):triton和模型部署+client

前言

先介绍TensorRT、Triton的关系和区别:

TensorRT:为inference(推理)为生,是NVIDIA研发的一款针对深度学习模型在GPU上的计算,显著提高GPU上的模型推理性能。即一种专门针对高性能推理的模型框架&…

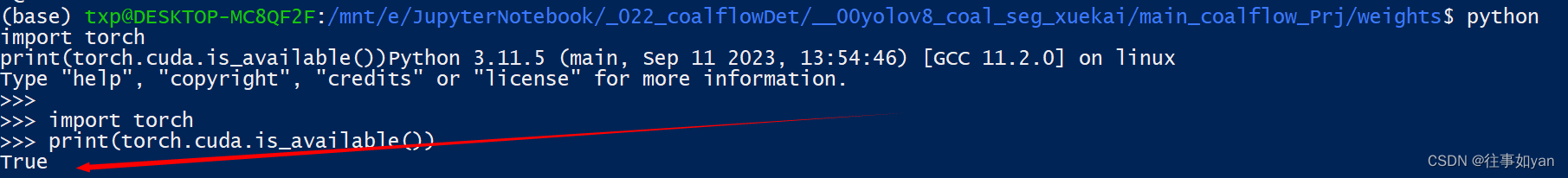

TensorRT_Win10上WSL实践篇

工程: 煤流检测 yolov8 的分割模型

环境:

首先打开WSL wsl -d Ubuntu-22.04 1. WSL升级WSL2(必做)

WSL v1不支持直接使用Windows的GPU,就算做了下面的所有步骤也没办法用,torch.cuda.is_available()会永…